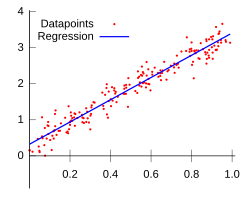

L'analisi della regressione è una tecnica usata per analizzare una serie di dati che consistono in una variabile dipendente e una o più variabili indipendenti. Lo scopo è stimare un'eventuale relazione funzionale esistente tra la variabile dipendente e le variabili indipendenti. La variabile dipendente nell'equazione di regressione è una funzione delle variabili indipendenti più un termine d'errore. Quest'ultimo è una variabile casuale e rappresenta una variazione non controllabile e imprevedibile nella variabile dipendente. I parametri sono stimati in modo da descrivere al meglio i dati. Il metodo più comunemente utilizzato per ottenere le migliori stime è il metodo dei "minimi quadrati" (OLS), ma sono utilizzati anche altri metodi.

Il data modeling può essere usato senza alcuna conoscenza dei processi sottostanti che hanno generato i dati;[1] in questo caso il modello è un modello empirico. Nella modellizzazione, inoltre, non è richiesta la conoscenza della distribuzione di probabilità degli errori. L'analisi della regressione richiede ipotesi riguardanti la distribuzione di probabilità degli errori. Test statistici vengono effettuati sulla base di tali ipotesi. Nell'analisi della regressione il termine "modello" comprende sia la funzione usata per modellare i dati che le assunzioni concernenti la distribuzione di probabilità.

L'analisi della regressione può essere usata per effettuare previsioni (ad esempio per prevedere dati futuri di una serie temporale), inferenza statistica, per testare ipotesi o per modellare delle relazioni di dipendenza. Questi usi della regressione dipendono fortemente dal fatto che le assunzioni di partenza siano verificate. L'uso dell'analisi della regressione è stato criticato in diversi casi in cui le ipotesi di partenza non possono essere verificate.[1][2] Un fattore che contribuisce all'uso improprio della regressione è che richiede più competenze per criticare un modello che per adattarlo.[3]

Storia

[modifica | modifica wikitesto]La prima forma di regressione fu il metodo dei minimi quadrati, pubblicato da Legendre nel 1805,[4] e da Gauss nel 1809.[5] Il termine “minimi quadrati” deriva dall'espressione francese usata da Legendre, moindres carrés. Tuttavia, Gauss affermò di essere a conoscenza di questo metodo fin dal 1795.

Legendre e Gauss applicarono entrambi il metodo al problema di determinare, a partire da osservazioni astronomiche, l'orbita dei pianeti attorno al Sole. Già Eulero aveva lavorato sullo stesso problema, intorno al 1748, ma senza successo.[senza fonte] Gauss pubblicò un ulteriore sviluppo della teoria dei minimi quadrati nel 1821,[6] includendo una versione del teorema di Gauss-Markov.

Il termine "regressione" venne coniato nel XIX secolo per descrivere il fenomeno biologico per il quale la progenie di individui eccezionali tende in genere ad essere meno eccezionale dei propri genitori e più simile ai loro avi più distanti. Francis Galton, un cugino di Charles Darwin, studiò questo fenomeno e usò i termini, vagamente fuorvianti, di "regressione verso il centro" e "regressione verso la media". Per Galton la regressione aveva solo questo significato biologico, ma il suo lavoro[7] venne in seguito esteso da Udny Yule e Karl Pearson in un contesto statistico più generale.[8] Oggi il termine "regressione" viene spesso usato come sinonimo di "curva intercetta dei minimi quadrati".

Presupposti

[modifica | modifica wikitesto]- Il campione deve essere rappresentativo della popolazione per la quale si vuole effettuare la previsione.

- La variabile dipendente è soggetta ad errore. Tale errore si assume sia una variabile casuale, con media zero. L'errore sistematico può essere presente ma il suo trattamento esula dallo scopo dell'analisi della regressione.

- Le variabili indipendenti non hanno errore. Se così non fosse, la modellizzazione dovrebbe essere fatta usando le tecniche errors-in-variables.

- Le variabili predittive devono essere linearmente indipendenti, ossia non deve essere possibile esprimere un qualunque predittore come combinazione lineare degli altri. Vedi multicollinearità.

- Gli errori sono incorrelati, ossia, la matrice di varianza e covarianza degli errori è diagonale e ogni elemento non-nullo è la varianza dell'errore.

- La varianza dell'errore è costante (omoschedasticità). In caso contrario, si deve utilizzare il metodo dei minimi quadrati pesati, o altri metodi.

- Gli errori seguono una distribuzione normale. Altrimenti, dovrebbe essere usato il modello lineare generalizzato.

Queste condizioni sono sufficienti (ma non tutte necessarie) perché lo stimatore dei minimi quadrati goda di buone proprietà. In particolare queste assunzioni implicano che lo stimatore sia non distorto, consistente ed efficiente nella classe degli stimatori lineari non distorti. Molte di queste assunzioni possono essere rilassate in analisi più avanzate.

Regressione lineare

[modifica | modifica wikitesto]Nella regressione lineare, il modello assume che la variabile dipendente, sia una combinazione lineare dei parametri (ma non è necessario che sia lineare nella variabile indipendente). Ad esempio, nella regressione lineare semplice con osservazioni ci sono una variabile indipendente: , e due parametri, e :

Nella regressione lineare multipla, ci sono più variabili indipendenti o funzioni di variabili indipendenti. Ad esempio, aggiungendo un termine in alla regressione precedente si ottiene:

Si tratta ancora di una regressione lineare: sebbene l'espressione sulla destra sia quadratica nella variabile indipendente , è comunque lineare nei parametri , e

In entrambi i casi, è un termine di errore e l'indice identifica una particolare osservazione. Dato un campione casuale della popolazione, stimiamo i parametri della popolazione e otteniamo il modello di regressione lineare semplice:

Il termine è il residuo, . Un metodo di stima è quello dei minimi quadrati ordinari. Questo metodo ottiene le stime dei parametri che minimizzano la somma dei quadrati dei residui, SSE:

La minimizzazione di questa funzione risulta essere un sistema di equazioni normali, un insieme di equazioni lineari simultanee nei parametri, che vengono risolte per trovare le stime dei parametri, . Vedi coefficienti di regressione per informazioni sulle proprietà statistiche di tali stimatori.

Nel caso della regressione semplice, le formule per le stime dei minimi quadrati sono

- e

dove è la media (media) dei valori e è la media dei valori . Sotto l'ipotesi che il termine di errore della popolazione abbia una varianza costante, la stima di quella varianza è data da: Questo è la radice dell'errore quadratico medio (RMSE) della regressione. Gli errori standard delle stime dei parametri sono dati da

Sotto l'ulteriore ipotesi che il termine di errore della popolazione abbia distribuzione normale, il ricercatore può usare questi errori standard stimati per creare intervalli di confidenza e condurre test d'ipotesi sui parametri della popolazione.

La regressione multipla

[modifica | modifica wikitesto]Nel più generale modello di regressione multipla, ci sono variabili indipendenti:

Le stime dei parametri dei minimi quadrati sono ottenute da equazioni normali. Il residuo può essere scritto come

Le equazioni normali sono

In notazione matriciale, le equazioni normali sono scritte come

Analisi di bontà del modello

[modifica | modifica wikitesto]Una volta costruito un modello di regressione, è importante confermare la bontà di adattamento del modello e la significatività statistica dei parametri stimati. I controlli della bontà di adattamento comunemente usati includono l'indice R-quadro, analisi dei residui e test di ipotesi. La significatività statistica è verificata con un test F dell'adattamento globale, seguito da t-test per ogni singolo parametro.

L'interpretazione di questi test dipende fortemente dalle assunzioni sul modello. Nonostante l'analisi dei residui sia usata per determinare la bontà di un modello, i risultati dei test-T e dei test-F sono difficili da interpretare nel caso in cui le assunzioni di partenza non siano soddisfatte. Ad esempio, se la distribuzione degli errori non è normale, può accadere che in campioni di numerosità ridotta le stime dei parametri non seguano una distribuzione normale, cosa che complica l'inferenza. Per grandi campioni, il teorema del limite centrale permette di effettuare i test usando un'approssimazione asintotica delle distribuzioni.

Regressione per variabili discrete: i modelli lineari generalizzati

[modifica | modifica wikitesto]La variabile risposta può essere non continua. Per le variabili binarie (zero/uno), si può procedere con un particolare tipo di modello lineare linear probability model. Se si usa un modello non-lineare i modelli più utilizzati sono il probit e il modello logit. Il modello probit multivariato rende possibile stimare congiuntamente la relazione tra più variabili binarie dipendenti e alcune variabili indipendenti. Per variabili categoriche con più di due valori si utilizza il modello logit multinomiale. Per variabili ordinali con più di due valori, si utilizzano i modelli logit cumulativo e probit cumulativo. Un'alternativa a tali procedure è la regressione lineare basata su polychoric o polyserial correlazioni tra le variabili categoriche. Tali procedure differiscono nelle ipotesi fatte sulla distribuzione delle variabili nella popolazione. Se la variabile rappresenta una ripetizione di un evento nel tempo, è positiva e con poche realizzazioni ("eventi rari"), si possono utilizzare modelli di Poisson o binomiale negativa.

Interpolazione e estrapolazione

[modifica | modifica wikitesto]I modelli di regressione predicono una variabile partendo dai valori di altre variabili . Se i valori della previsione sono compresi nell'intervallo dei valori delle variabili utilizzate per la costruzione del modello si parla di interpolazione. Se i valori escono dal range delle variabili esplicative si parla di estrapolazione. In questo caso la previsione diventa più rischiosa.

Regressione non lineare

[modifica | modifica wikitesto]Quando la funzione del modello non è lineare nei parametri la somma dei quadrati deve essere minimizzata da una procedura iterativa.

Altri metodi

[modifica | modifica wikitesto]Sebbene i parametri di un modello di regressione siano di solito stimati usando il metodo dei minimi quadrati, altri metodi includono:

- metodi Bayesiani, per esempio la regressione lineare Bayesiana;

- minimizzazione delle deviazioni assolute, che porta alla regressione dei quantili;

- regressione non parametrica, tale approccio richiede un ampio numero di osservazioni, poiché i dati sono usati sia per costruire la struttura del modello che per stimare i parametri del modello. Normalmente richiedono un elevato sforzo computazionale.

Software

[modifica | modifica wikitesto]Tutti i principali pacchetti statistici eseguono i tipi comuni di analisi di regressione correttamente e in modo semplice. La regressione lineare semplice può essere fatta in alcuni fogli elettronici. C'è una quantità di programmi che esegue forme specializzate di regressione, e gli esperti possono scegliere di scrivere il loro proprio codice per usare linguaggi di programmazione statistica o software per analisi numerica.

Note

[modifica | modifica wikitesto]- 1 2 Richard A. Berk, Regression Analysis: A Constructive Critique, Sage Publications (2004)

- ↑ David A. Freedman, Statistical Models: Theory and Practice, Cambridge University Press (2005)

- ↑ R. Dennis Cook; Sanford Weisberg "Criticism and Influence Analysis in Regression", Sociological Methodology, Vol. 13. (1982), pp. 313-361.

- ↑ A.M. Legendre. Nouvelles méthodes pour la détermination des orbites des comètes (1805). “Sur la Méthode des moindres quarrés” appears as an appendix.

- ↑ C.F. Gauss. Theoria Motus Corporum Coelestium in Sectionibus Conicis Solem Ambientum. (1809)

- ↑ C.F. Gauss. Theoria combinationis observationum erroribus minimis obnoxiae. (1821/1823)

- ↑ Francis Galton. "Typical laws of heredity", Nature 15 (1877), 492-495, 512-514, 532-533. (Galton usa il termine "reversion" in questo articolo, che tratta della grandezza dei piselli.); Francis Galton. Presidential address, Section H, Anthropology. (1885) (in questo documento,che tratta dell'altezza degli esseri umani, Galton utilizza il termine "regressione".)

- ↑ G. Udny Yule. "On the Theory of Correlation", J. Royal Statist. Soc., 1897, p. 812-54. Karl Pearson, G. U. Yule, Norman Blanchard, e Alice Lee. "The Law of Ancestral Heredity", Biometrika (1903). Nel lavoro di Yule e Pearson, la distribuzione congiunta della variabile risposta e delle variabili esplicative è ipotizzata essere una distribuzione normale. Questa ipotesi fu notevolmente indebolita da R.A. Fisher nei suoi lavori del 1922 e del 1925 (R.A. Fisher, "The goodness of fit of regression formulae, and the distribution of regression coefficients", J. Royal Statist. Soc., 85, 597-612 del 1922 e Statistical Methods for Research Workers del 1925). Fisher ipotizzava che la distribuzione condizionata della variabile risposta fosse normale, ma non poneva condizioni sulla distribuzione congiunta. Sotto questo aspetto, l'ipotesi di Fisher è più vicina alla formulazione di Gauss del 1821.

Bibliografia

[modifica | modifica wikitesto]- Audi, R., Ed. (1996). "curve fitting problem," The Cambridge Dictionary of Philosophy. Cambridge, Cambridge University Press. pp. 172–173.

- William H. Kruskal e Judith M. Tanur, ed. (1978), "Linear Hypotheses," International Encyclopedia of Statistics. Free Press, v. 1,

- Evan J. Williams, "I. Regression," pp. 523-41.

- Julian C. Stanley, "II. Analysis of Variance," pp. 541-554.

- Lindley, D.V. (1987). "Regression and correlation analysis," New Palgrave: A Dictionary of Economics, v. 4, pp. 120–23.

- Birkes, David e Yadolah Dodge, Alternative Methods of Regression. ISBN 0-471-56881-3

- Chatfield, C. (1993) "Calculating Interval Forecasts," Journal of Business and Economic Statistics, 11. pp. 121–135.

- Draper, N.R. e Smith, H. (1998).Applied Regression Analysis Wiley Series in Probability and Statistics

- Fox, J. (1997). Applied Regression Analysis, Linear Models and Related Methods. Sage

- Hardle, W., Applied Nonparametric Regression (1990), ISBN 0-521-42950-1

- Meade, N. e T. Islam (1995) "Prediction Intervals for Growth Curve Forecasts," Journal of Forecasting, 14, pp. 413–430.

- Munro, Barbara Hazard (2005) "Statistical Methods for Health Care Research" Lippincott Williams & Wilkins, 5th ed.

- Gujarati, Basic Econometrics, 4ª edizione

- Sykes, A.O. "An Introduction to Regression Analysis" (Inaugural Coase Lecture)

- S. Kotsiantis, D. Kanellopoulos, P. Pintelas, Local Additive Regression of Decision Stumps, Lecture Notes in Artificial Intelligence, Springer-Verlag, Vol. 3955, SETN 2006, pp. 148 – 157, 2006

- S. Kotsiantis, P. Pintelas, Selective Averaging of Regression Models, Annals of Mathematics, Computing & TeleInformatics, Vol 1, No 3, 2005, pp. 66–75

Voci correlate

[modifica | modifica wikitesto]- Confidence region

- Distanza di Cook

- Distribuzione normale multivariata

- Estrapolazione

- Forecasting

- Funzione di Huber

- Intervallo di confidenza

- Intervallo di previsione

- Kriging (un algoritmo di stima dei minimi quadrati lineari)

- Robust regression

- Segmented regression

- Statistica

- Stima del trend

Altri progetti

[modifica | modifica wikitesto] Wikimedia Commons contiene immagini o altri file sull'analisi della regressione

Wikimedia Commons contiene immagini o altri file sull'analisi della regressione

Collegamenti esterni

[modifica | modifica wikitesto]- (EN) regression analysis, su Enciclopedia Britannica, Encyclopædia Britannica, Inc.

- (EN) IUPAC Gold Book, "regression analysis", su goldbook.iupac.org.

- Exegeses on Linear Models - Alcuni commenti sui modelli di regressione lineare by Bill Venables.

| Controllo di autorità | LCCN (EN) sh85112392 · GND (DE) 4129903-6 · BNF (FR) cb119445648 (data) · J9U (EN, HE) 987007529518905171 · NDL (EN, JA) 00564579 |

|---|